Mindste kvadraters metode

Der er for få eller ingen kildehenvisninger i denne artikel, hvilket er et problem. Du kan hjælpe ved at angive troværdige kilder til de påstande, som fremføres i artiklen.

Der er for få eller ingen kildehenvisninger i denne artikel, hvilket er et problem. Du kan hjælpe ved at angive troværdige kilder til de påstande, som fremføres i artiklen.

Mindste kvadraters metode er en standard fremgangsmåde til at finde den bedste løsning for et overbestemt system, for eksempel et ligningssystem med flere ligninger end ubekendte. Den bedste, skal her forstås som dén løsning der giver den mindste sum af kvadraterne på fejlene i hver enkelt ligning.

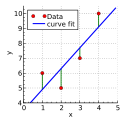

Mindste kvadraters metode benyttes blandt andet i regressionsanalyse, for eksempel til at finde den bedste rette linje der beskriver en linær sammenhæng mellem to dataset. Metoden minimerer her summen af kvadraterne på residualerne (de lodrette afstande mellem de enkelte punkter og den rette linje).

Dette kan gøres grafisk ved at tegne punkterne fra et datasæt ind i et koordinatsystem og tegne en ret linje, som ligger nogenlunde der, hvor man tror, den bedste rette linje kan ligge. Herefter tegnes de lodrette afstande mellem punkterne og linjen. Disse punkter kvadreres så. Afstanden mellem punktet og linjen er den ene side i et kvadrat. Man kan så rykke rundt på linjen ved at rotere den og parallelforskyde den, indtil det samlede areal af alle kvadraterne er mindst muligt. Heraf navnet ”Mindste kvadraters metode”.

Der er dog også en anden mulighed, som man kan bruge, hvis man vil slippe for det grafiske. Denne måde er god, da den er mere præcis og mere tilgængelig, hvis man skal regne det i hånden:

Når man har den lodrette afstand mellem punktet og linjen, sætter man afstanden i anden og lægger den sammen med alle de andre punkters kvadrerede afstande. Det udtryk, man her får, skal differentieres. Først differentieres det med hensyn til den ene ubekendte konstant, derefter differentieres det med den anden ubekendte konstant. På dette tidspunkt har man fået to ligninger med to ubekendte. For at løse disse ligninger isolerer man først den ene ubekendte konstant i den ene ligning, hvorefter man sætter resultatet ind på den ubekendte konstants plads i den anden ligning. Bagefter gøres det samme med den anden ubekendte. Når man har fundet de to værdier, kan man sætte dem ind i ligningen for en lineær regression. Man har nu forskriften for den bedste rette linje.

Regressioner

Proportionalitet

En af de simple modeller, man kan fitte sine data til er den proportionale, der er en lineær regression, hvor man kræver, at skæringen med y-aksen er lig med nul. Modellen er altsâ givet ved:

Det ses, at det eneste parameter, vi skal bestemme, er . For et givent datapunkt er afstanden til fittet altså:

Dermed er arealet af det tilhørende kvadrat givet ved:

Det totale kvadratareal er summen af de enkelte arealer:

For at finde det , der minimerer arealet, vil vi sætte differentialkvotienten af mht. lig med 0. Løsningen til denne ligning kan vi kalde .

Denne ligning kan vi nu løse:

Hvis vi på begge sider af brøkstregen dividerer med antallet af datapunkter, får vi vores estimat udtrykt i forventningsværdier i stedet:

Vi har nu et estimat for hældningen af en proportional sammenhæng givet de målte X- og Y-værdier.

Linearitet

Vi kan nu gøre modellen mere kompliceret ved at lade skæring med y-aksen være en fri parameter. Vores model vil da hedde:

- ,

Vi skal nu estimere både og . Vores samlede kvadratareal er givet ved:

Vi får her et udtryk for den afledte for hver parameter. Når vi afleder med hensyn til skal holdes konstant og omvendt, hvilket vil sige, at vi bruger partielle afledte. Vi har for at:

Som før kan den estimerede værdi markeres med en tilde, og den afledte kan sættes lig nul:

Hvis vi har datapunkter, kan vi omskrive summen af . For :

Så:

Vi har nu et ligningssystem med to ligninger og to ukendte parametre:[1]

Vi kan starte med at isolere i den første ligning:

Dette kan nu indsættes i den anden ligning:

Vi har nu et estimat for a. Dette kan indsættes i udtrykket for :

Vi har nu endelig to færdige udtryk for at finde en lineær regression vha. mindste kvadraters metode:[2]

Kildehenvisninger

- ^ Bemærk at den anden ligning er ækvivalent med udtrykket, vi fandt, for proportionalitet, hvis vi sætter lig med nul.

- ^ Miller, Steven J.: "The Method of Least Squares". Internetadresse: The Method of Least Squares - Opdateret maj 2007 – Besøgt d. 21.10.2015 (Internet)

| Spire Denne artikel om matematik er en spire som bør udbygges. Du er velkommen til at hjælpe Wikipedia ved at udvide den. |

Medier brugt på denne side

Greek lowercase pi icon

Forfatter/Opretter: Krishnavedala, Licens: CC BY-SA 3.0

Illustration of least squares fitting. The data (red dots) are at co-ordinates (1,6), (2,5), (3,7) and (4,10). A linear approximation is obtained using least-squares estimation (blue line). Created using python.